huggingface 从镜像下载

pip install -U huggingface_hub

set HF_ENDPOINT=https://hf-mirror.com

huggingface-cli download Qwen/QwQ-32B-GGUF --local-dir Qwen/QwQ-32B-GGUF

Conda

https://www.anaconda.com/download

安装后需要把 condabin 目录加到环境变量中。

conda的工作流程:

输入命令,告诉conda要安装的package

conda从channel中下载指定的package。(channel是一个托管着很多package的仓库)

默认的channel服务器在国外下载缓慢,可以配置成清华的channel;

执行命令在用户目录下生成 .condarc 文件conda config --set show_channel_urls yes

打开.condarc文件,将 https://mirrors.tuna.tsinghua.edu.cn/help/anaconda/ 中的配置信息粘贴进去。

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/r

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

pytorch: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

常见的channe1:

- Defaults:Conda的默认channel

- CondaForge:一个社区驱动的channel,包含大显的开源软件包,很多包在CondaForge上更新得更

快。 - PyTorch:由PyTorch团队维护的chanmel,用于安装PyTorch及其相关库。

- NVIDIA:由NVIDIA提供的channel,包含CUDA工具包、cuDNN以及其他GPU加速的库。

pip:

pip 的包来源是 PyPI(Python Package Index),这是 Python 的官方包仓库,包含了几乎所有 Python 包。

PyPI 是一个开放的社区驱动的平台,任何人都可以上传自己的包。

conda:

conda 的包来源主要是 Anaconda 官方渠道 和 conda-forge(社区维护的渠道)。

Anaconda 官方渠道主要包含科学计算、数据分析相关的包,而 conda-forge 则包含了更多社区贡献的包。

不是所有的 PyPI 包都会被移植到 Conda 渠道中。

使用下列命令清除索引缓存,并安装常用包测试一下。

conda clean -i

conda create -n myenv numpy

创建一个空环境

conda create --name {env_name} #此处 --name 也可以简写成 -n

conda create --name myenv

在创建环境时指定python版本和一些所需的包。

conda create --name {env_name} {python=x.x.x} package1 package2

conda create --name myenv python=3.7.5 pandas numpy

激活环境

conda activate {env_name}

停用环境

conda deactivate

conda install pkg_name1=x.x.x pkg_name2=x.x.x #安装包

conda list # 查看当前环境中的包

conda list -n {env_name} # 查看指定环境中的包

conda env list

#or

conda info --envs # --envs可以简写成 -e

conda env remove -n env_name # 删除环境

conda install -C conda-forge numpy # 指定channel

open-webui

安装 ffmpeg https://github.com/BtbN/FFmpeg-Builds/releases,bin 配置到环境变量

安装 open-webui,windows 下需管理员启动命令行

conda create --name py311 python=3.11

conda activate py311

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple/

pip install open-webui

set HF_ENDPOINT=https://hf-mirror.com

open-webui serve

启动

conda activate py311

open-webui serve

██████╗ ██████╗ ███████╗███╗ ██╗ ██╗ ██╗███████╗██████╗ ██╗ ██╗██╗

██╔═══██╗██╔══██╗██╔════╝████╗ ██║ ██║ ██║██╔════╝██╔══██╗██║ ██║██║

██║ ██║██████╔╝█████╗ ██╔██╗ ██║ ██║ █╗ ██║█████╗ ██████╔╝██║ ██║██║

██║ ██║██╔═══╝ ██╔══╝ ██║╚██╗██║ ██║███╗██║██╔══╝ ██╔══██╗██║ ██║██║

╚██████╔╝██║ ███████╗██║ ╚████║ ╚███╔███╔╝███████╗██████╔╝╚██████╔╝██║

╚═════╝ ╚═╝ ╚══════╝╚═╝ ╚═══╝ ╚══╝╚══╝ ╚══════╝╚═════╝ ╚═════╝ ╚═╝

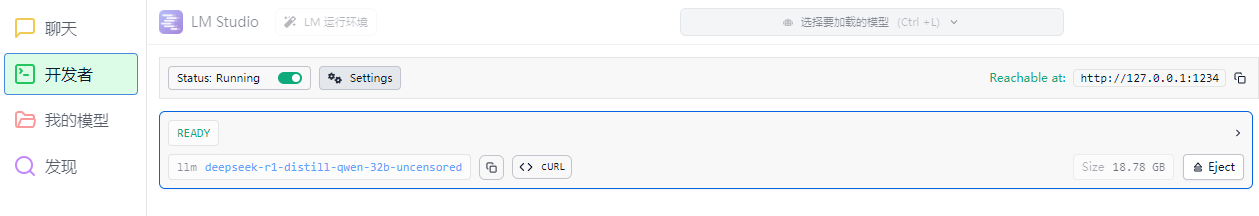

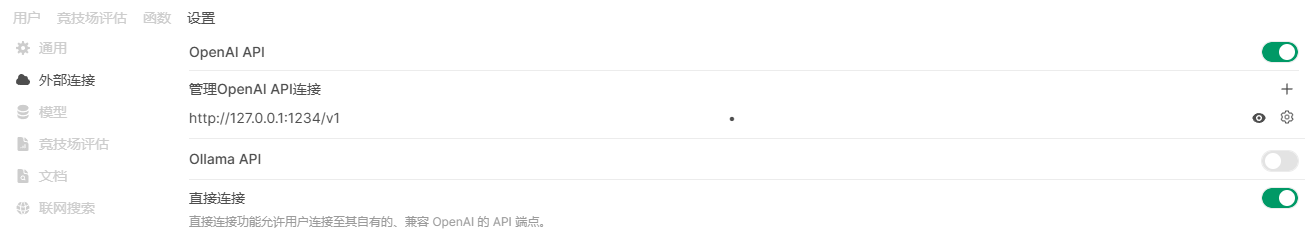

open-webui 连接本地ollama和lm_studio

启动 lm_studio

设置 open-webui 管理面板:

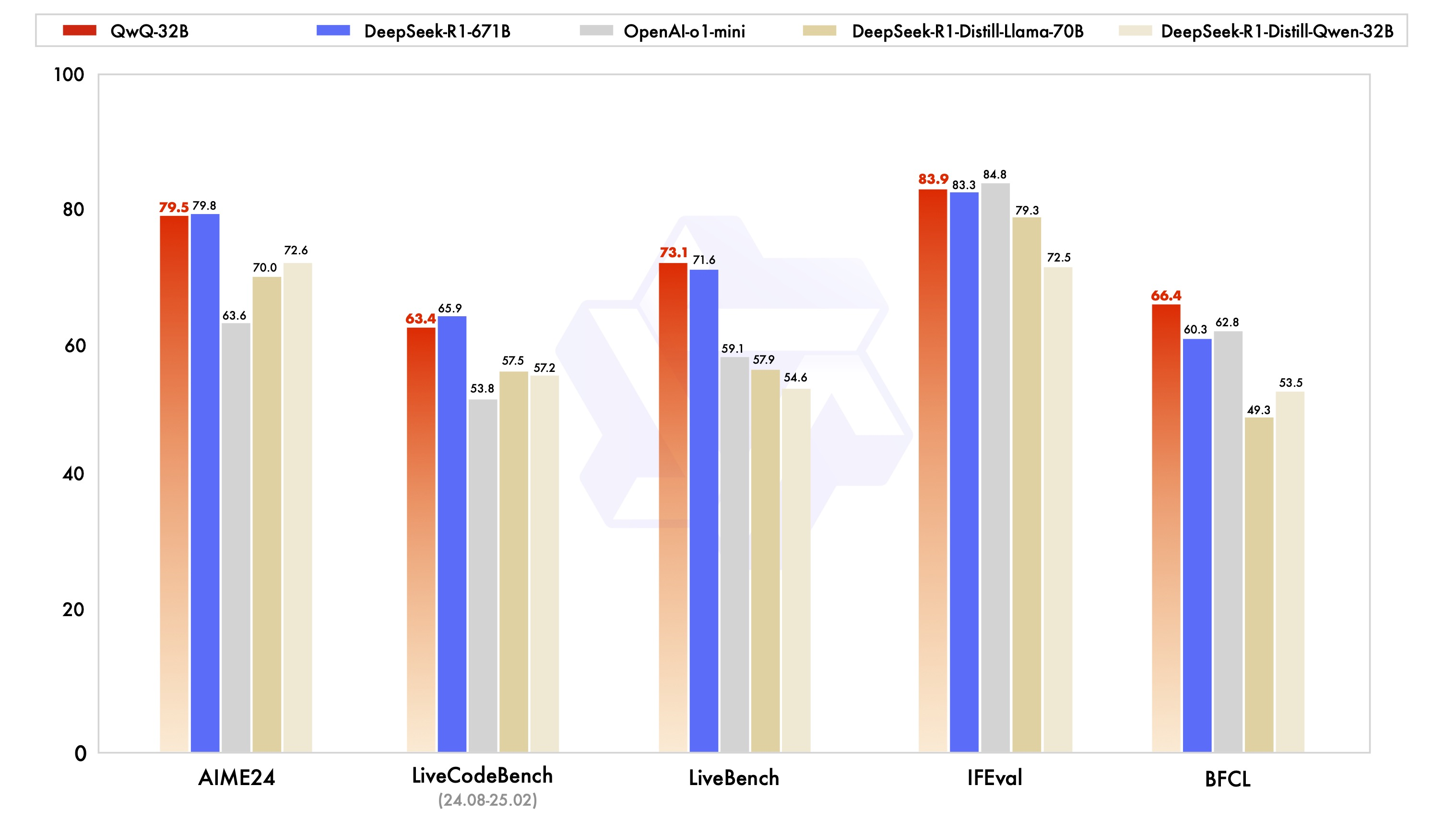

QwQ 32B

https://huggingface.co/Qwen/QwQ-32B-GGUF

QwQ 号称超过了 R1 满血版或者相近,实测同参数量级,确实是比DeepSeek 32B、70B 聪明,但和R1满血可能还有点差距。但是对显存的资源消耗少了很多,我在2080Ti 22G显卡也可以流畅的运行 q4 量化。

量化:q2_K, q3_K_M, q4_0, q4_K_M, q5_0, q5_K_M, q6_K, q8_0

lmstudio v0.33.11 会报错: 解析 Jinja 模板失败: Parser Error: Expected closing statement token. OpenSquareBracket !== CloseStatement.,需要替换提示模板如下:

{%- if tools %} {{- '<|im_start|>system\n' }} {%- if messages[0]['role'] == 'system' %} {{- messages[0]['content'] }} {%- else %} {{- '' }} {%- endif %} {{- "\n\n# Tools\n\nYou may call one or more functions to assist with the user query.\n\nYou are provided with function signatures within <tools></tools> XML tags:\n<tools>" }} {%- for tool in tools %} {{- "\n" }} {{- tool | tojson }} {%- endfor %} {{- "\n</tools>\n\nFor each function call, return a json object with function name and arguments within <tool_call></tool_call> XML tags:\n<tool_call>\n{\"name\": <function-name>, \"arguments\": <args-json-object>}\n</tool_call><|im_end|>\n" }} {%- else %} {%- if messages[0]['role'] == 'system' %} {{- '<|im_start|>system\n' + messages[0]['content'] + '<|im_end|>\n' }} {%- endif %} {%- endif %} {%- for message in messages %} {%- if (message.role == "user") or (message.role == "system" and not loop.first) %} {{- '<|im_start|>' + message.role + '\n' + message.content + '<|im_end|>' + '\n' }} {%- elif message.role == "assistant" and not message.tool_calls %} {%- set content = (message.content.split('</think>')|last).lstrip('\n') %} {{- '<|im_start|>' + message.role + '\n' + content + '<|im_end|>' + '\n' }} {%- elif message.role == "assistant" %} {%- set content = (message.content.split('</think>')|last).lstrip('\n') %} {{- '<|im_start|>' + message.role }} {%- if message.content %} {{- '\n' + content }} {%- endif %} {%- for tool_call in message.tool_calls %} {%- if tool_call.function is defined %} {%- set tool_call = tool_call.function %} {%- endif %} {{- '\n<tool_call>\n{"name": "' }} {{- tool_call.name }} {{- '", "arguments": ' }} {{- tool_call.arguments | tojson }} {{- '}\n</tool_call>' }} {%- endfor %} {{- '<|im_end|>\n' }} {%- elif message.role == "tool" %} {%- if (loop.index0 == 0) or (messages[loop.index0 - 1].role != "tool") %} {{- '<|im_start|>user' }} {%- endif %} {{- '\n<tool_response>\n' }} {{- message.content }} {{- '\n</tool_response>' }} {%- if loop.last or (messages[loop.index0 + 1].role != "tool") %} {{- '<|im_end|>\n' }} {%- endif %} {%- endif %} {%- endfor %} {%- if add_generation_prompt %} {{- '<|im_start|>assistant\n' }} {%- endif %}

为了获得最佳性能,建议进行以下设置:

强制深思熟虑的输出:

确保模型以"

采样参数:

使用Temperature=0.6和TopP=0.95代替贪婪解码,以避免无休止的重复。

使用 20 到 40 之间的 TopK 来滤除罕见的 token 出现,同时保持生成输出的多样性。

历史中不包含思考内容:

在多轮对话中,历史模型输出应该只包含最后的输出部分,不需要包含思考内容。该功能已在apply_chat_template中实现。

标准化输出格式:

我们建议在基准测试时使用提示来标准化模型输出。

数学问题:在提示中包含“请逐步推理,并将最终答案放在 \boxed{} 内。”。

多项选择题:在提示中添加以下 JSON 结构以标准化响应:“请在answer字段中仅使用选择字母显示您的选择,例如, "answer": "C" 。 ”在提示中。

处理长输入:对于超过 32,768 个 token 的输入,启用YaRN以提高模型有效捕获长序列信息的能力。目前,只有 vLLM 支持 YARN 进行长度推断。如果您想处理最多 131,072 个 token 的序列,请参考非 GGUF 模型。

版权声明

本文章由作者“衡于墨”创作,转载请注明出处,未经允许禁止用于商业用途

本文章由作者“衡于墨”创作,转载请注明出处,未经允许禁止用于商业用途

评论区#

还没有评论哦,期待您的评论!

引用发言