LM Studio 本地部署大模型

关于 LM Studio

一个可以本地部署大模型的桌面应用,支持搜索下载 Hugging Face 上的大模型到本地运行,兼容 OPEN AI 的对外协议,可以管理模型和运行配置。支持本地 RAG 功能。

https://lmstudio.ai/docs/basics

本地部署 LLM

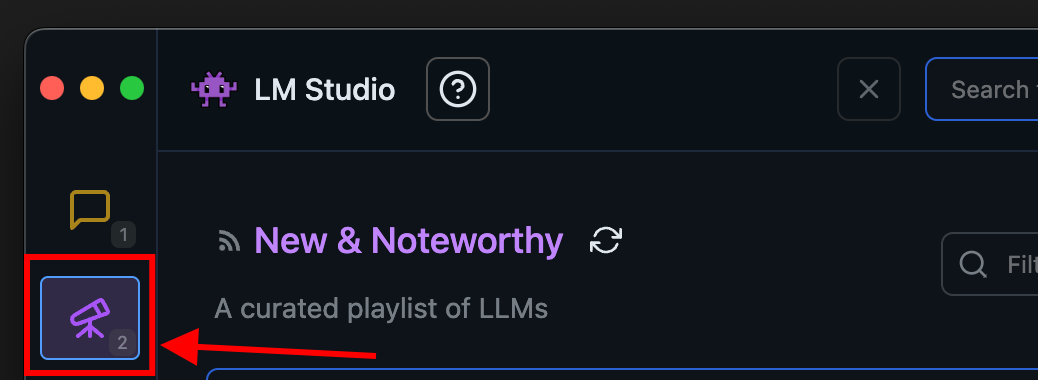

在 LM Studio 搜索并下载模型:

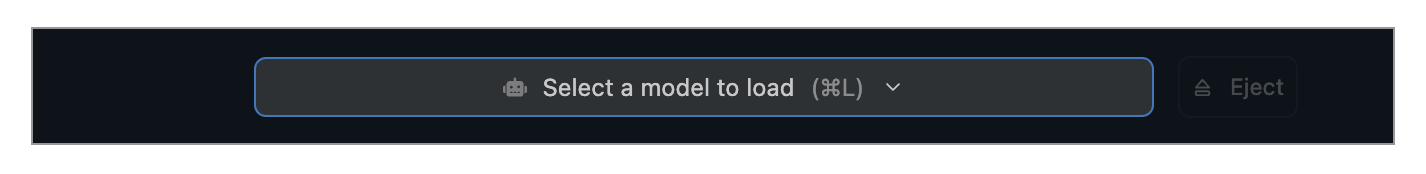

选择加载模型:

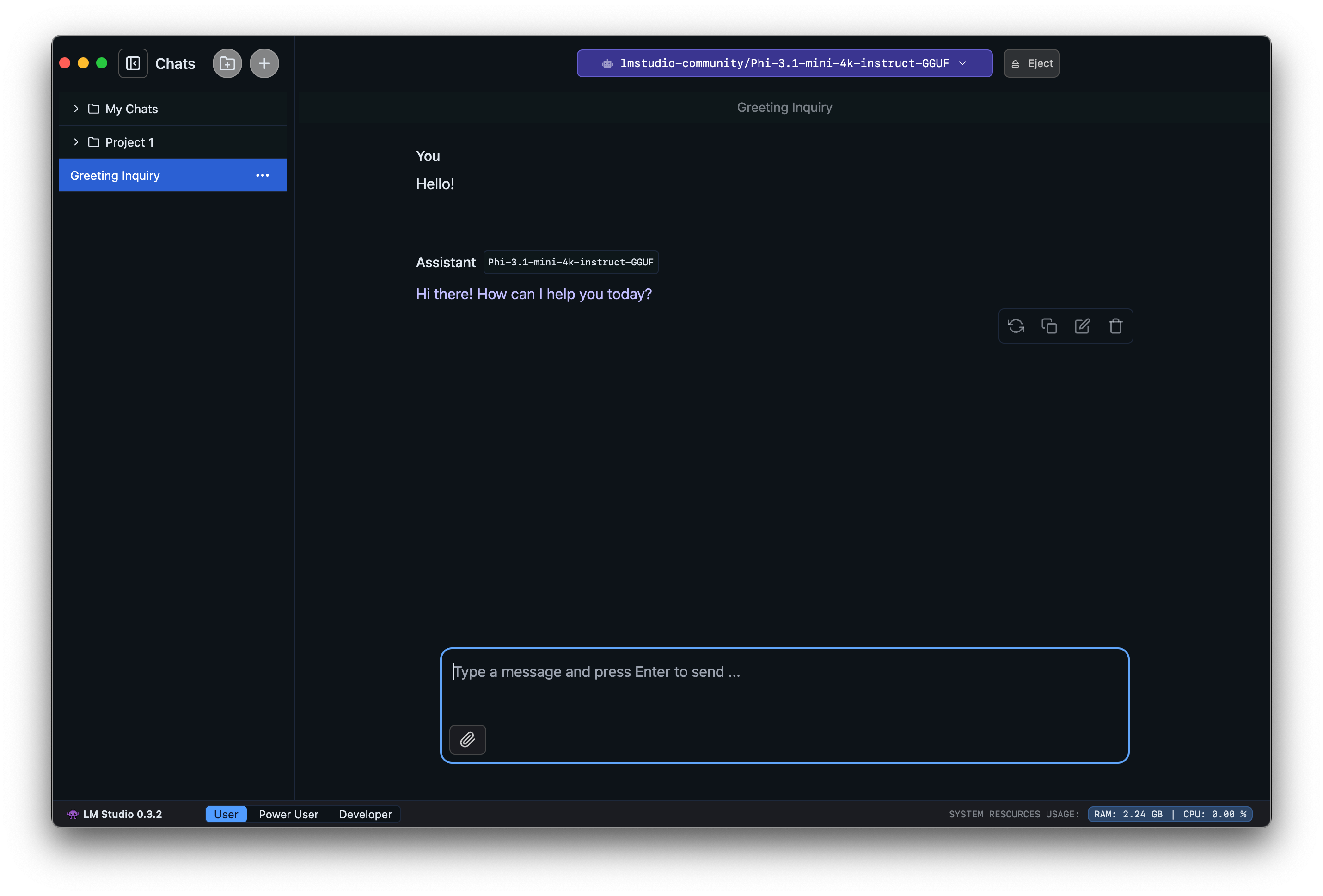

然后可以和模型对话:

RAG

如果文档足够短(即,如果它适合模型的上下文),LM Studio 会将文件内容完整添加到对话中。这对于支持较长上下文大小的模型(如 Meta 的 Llama 3.1 和 Mistral Nemo)特别有用。

如果文档很长,LM Studio 将选择使用“检索增强生成”,通常称为“RAG”。RAG 意味着尝试找出非常长的文档(或多个文档)的相关部分并将其提供给模型以供参考。这种技术有时效果很好,但有时需要进行一些调整和实验。

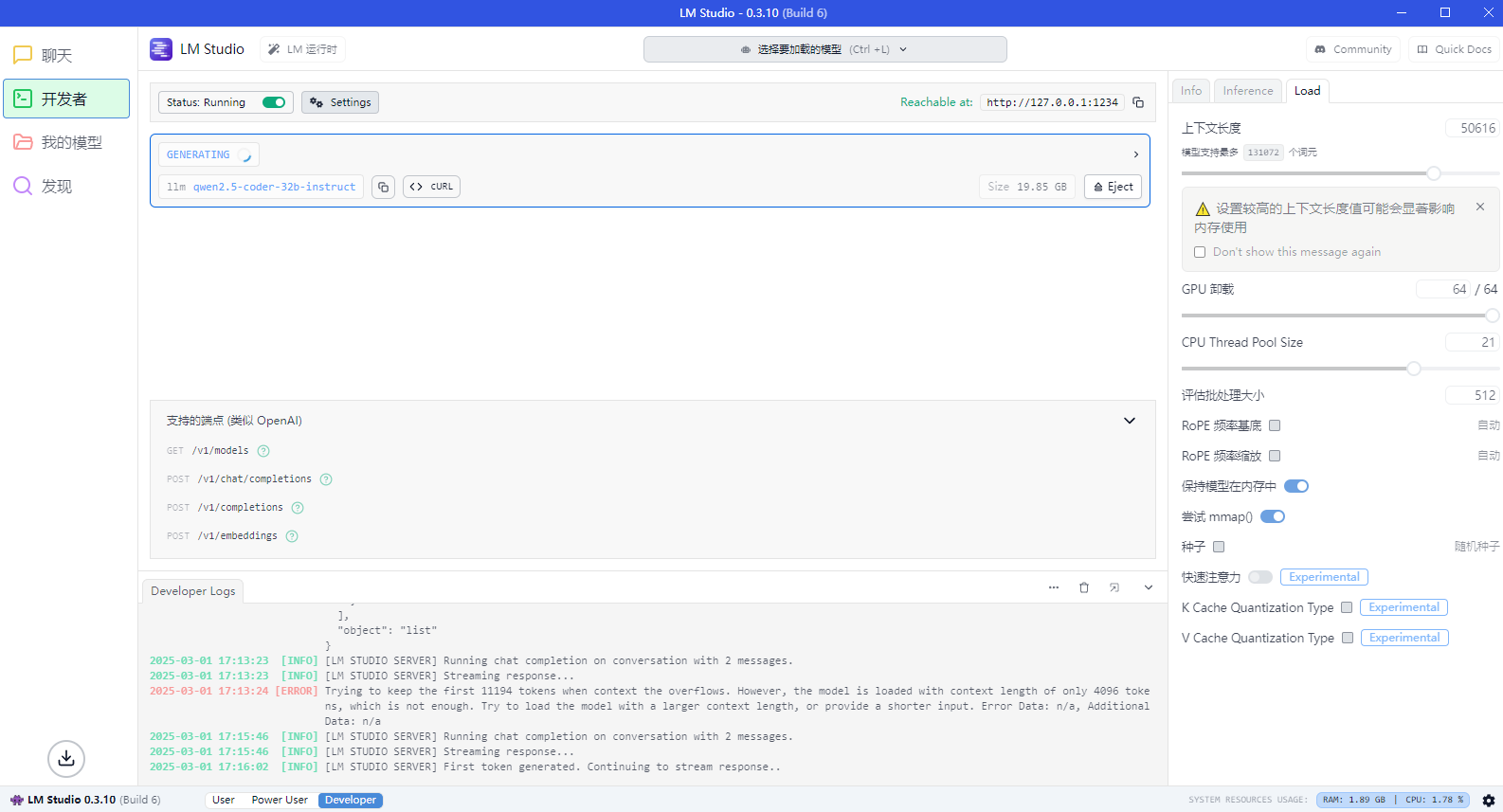

开发者模式

支持配置很多选项,如上下文长度、温度

版权声明

本文章由作者“衡于墨”创作,转载请注明出处,未经允许禁止用于商业用途

本文章由作者“衡于墨”创作,转载请注明出处,未经允许禁止用于商业用途

发布时间:2025年03月01日 15:20:04

备案号: 闽ICP备19015193号-1

闽ICP备19015193号-1

关闭特效

评论区#

还没有评论哦,期待您的评论!

引用发言